参加多人视频会议,只有自己是真人!AI诈骗怎么防?

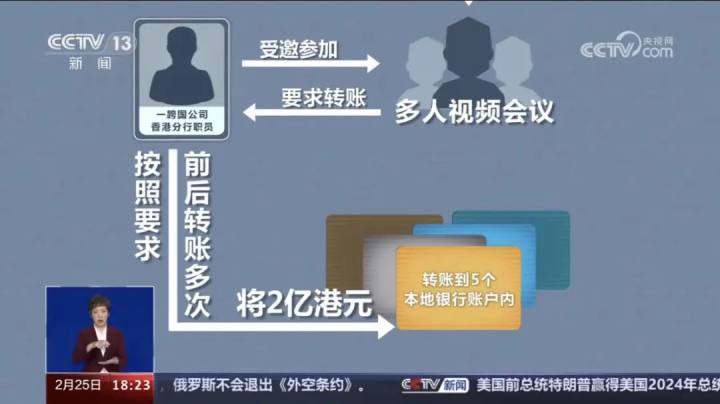

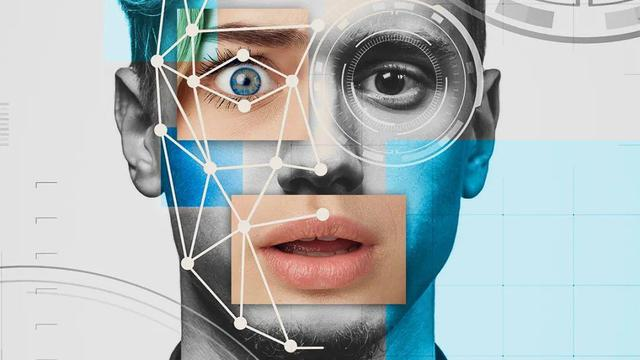

AI换脸

眼见不再为实!AI以假乱真的时代,我们如何确保真实?

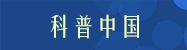

最近,香港警方披露了一起AI“多人换脸”诈骗案,涉案金额高达2亿港元。

被骗的是一家跨国公司香港分部的职员,他被邀请参加一场由总部首席财务官发起的“多人视频会议”,并按照要求,将2亿港元分多次转账到了5个本地银行账户内。

来源 | 央视网

其后向总部确认时,该员工才发现自己受骗。

警察调查后发现,在那个视频会议里,只有员工一个是真人,其他参会人全都是骗子用AI换脸技术伪造的!

据了解,诈骗者通过盗取该公司的YouTube视频和其他公开渠道媒体资料,巧妙地复制了公司高层管理人员的外貌和声音。然后,他们运用深度伪造技术,制作出诈骗视频,让受害者误以为其正在多人视频会议中,与其他真实人员交流。

深度伪造技术是啥?

深度伪造(Deepfake)是由深度学习(Deeplearning)和伪造(Fake)组合成的名词。

原本,这种对视频或图片进行调整的人工智能技术只是一种有趣的新突破,能够将一个人的面部表情、说话内容和动作放到别人的图片或视频上,并且看起来十分真实。

来源 | 央视网

由于这种技术很方便、成本低、效果逼真,给艺术、社交、医疗等领域都带来了很多新的机会。

但是,由于这种技术使得制作假视频变得更加容易,一些不法分子可能会利用它来骗人、传播假消息或制造社会矛盾,给我们的安全带来了很大的风险。

在AI面前,“有图有真相”和“眼见为实”的定律都被颠覆了。

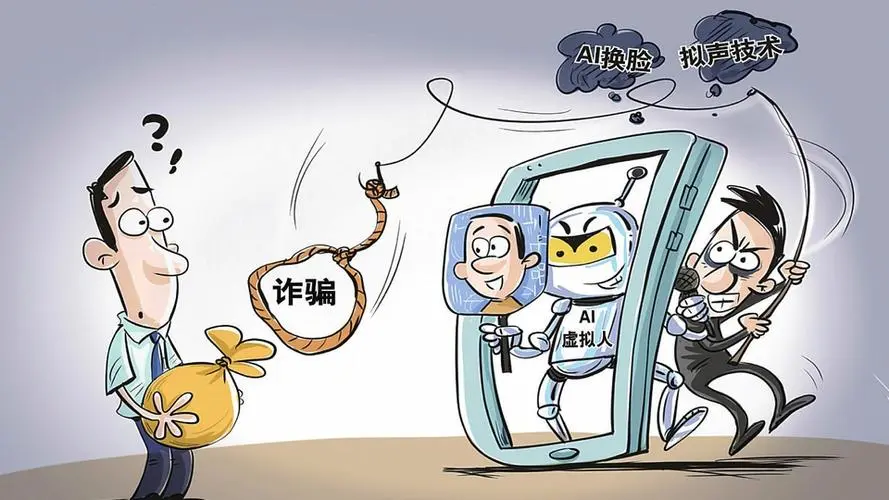

AI诈骗一般什么样?

在生活中,遇到亲戚朋友线上借钱,谨慎的人一般会选择和对方打个语音或视频电话,确认对方的身份后再转账。

但是,如果接电话的“亲戚朋友”也是骗子用AI伪造的呢?

来源 | 新华社

利用了AI技术的骗局,通常包含以下几个步骤:

1、盗取目标对象的社交账号,寻找潜在的受害者;

2、 利用AI机器人拨打骚扰电话,收集目标对象(改为目标亲友)的声音资料,进行声音伪造;

3、 通过多种渠道搜集目标亲友的照片、视频等资料,通过AI换脸伪装成目标对象亲友;

4、利用AI换脸技术,与受害人进行视频通话,以获取他们的信任,从而实施诈骗。

经过这三步操作,以往通过“发送语音”或“进行视频通话”来防范诈骗的方法在AI诈骗面前变得不再有效。

来源 | 澎湃

更令人担忧的是,掌握AI技术的骗子数量正在不断增加。公开资料显示,自2021年以来,多个省份都出现了利用AI进行诈骗和不当牟利的案件。中国互联网协会也指出,利用“AI换脸”和“AI换声”等技术进行诈骗和诽谤的违法行为频繁出现。

学会几招,及时识别AI伪造

如此以假乱真的诈骗方式,我们到底该如何防范呢?

1、要求视频对象在脸前挥手,或者捏鼻子、按脸颊

在视频电话时,挥手会干扰面部的数据,导致伪造的人脸出现抖动、闪现或其他异常情况,因此我们可以要求对方在脸部前面挥手进行识别。

另外,我们还可以让对方尝试按压鼻子或脸部,观察其面部变化。真人的鼻子在被按压时会发生变形,但AI生成的鼻子则不会。

但随着AI训练日趋成熟以后,捏鼻子也不是最保险的识别方法。

来源 | 央视网

2、问一些只有对方知道的问题

尽管外形可以被伪造,但个人的记忆和经历是无法被复制的。

因此,在视频通话中,我们可以问一些只有对方知道的问题,如家庭地址、生日、宠物名字等私人信息。如果对方在回答时表现出犹豫或无法准确回答,那么这很可能是一个诈骗行为。

来源|文心一格(图片由AI绘制)

加利福尼亚大学伯克利分校信息学院副院长法里德表示:“当新闻、图像、音频、视频——任何事情都可以伪造时,那么在那个世界里,就没有什么是真实的。”

当我们踏入AI以假乱真的时代,确保真实性的挑战似乎比任何时候都更加艰巨。

然而,面对这场技术革命,我们并非束手无策。通过技术素养的提升、全球合作和公众教育,我们有信心能够应对挑战,维护信息的真实与可信。